Vincent F. Hendricks: Er det forsvarligt, at mere og mere menneskelig overvejelse, beslutning og handling udliciteres til generativ AI?

31.08.2023

.På dags dato har den kinesiske regering givet grønt lys til, at Baidu kan lancere deres version af en generativ AI i det globale kapløb om vores opmærksomhed, data og begavelse. Men generativ AI behøver ikke engang blive klogere end os. Blot den kan udnytte vores kognitive og emotionelle egenskaber som svagheder er rigeligt til at realisere noget, der minder om Terminator-universet og dermed vores fortabelse. Det mest forstemmende er, at det i så fald vil være en selvpåført smerte, vi mennesker med åbne øjne, åbent sind og blottede følelser taber os selv i.

Essay af Vincent F. Hendricks

I videnskab, uddannelse, journalistik, statsadministration, kunst, kultur, kæresterelationer og klassekamp ansporer kunstig intelligens i disse dage til reaktioner fra hele den menneskelige følelsespalette; fra fascination til frelse, fra frustration til fortabelse. Senest er BigTech-ambitionen den, at såkaldt generativ AI kan få en rolle at spille i selvsamme følelsesliv. Det vil i værste fald betyde at lade følelserne være dikteret af terningekast og bullshit – førstehåndsforbindelsen fra frelse til menneskelig fortabelse.

Den selvgenererende intelligens

De seneste år har vi set en veritabel skov af kunstige intelligens-systemer vokse frem med rødder i, hvad der i branchen betegnes generativ AI. Netop i dag har kineserne meldt deres entre med Baidus Ernie Bot som modsvar til Google, Microsoft, Apple og de andre store aktørers nylige generative AI produkter. Generativ AI henviser i al væsentlighed til systemer og digitale værktøjer, der er i stand til at generere forskellige typer af indhold, hvad enten det hidrører tekst, billedmateriale eller computerkode. Det sker ved at ekstrapolere fra mønstre, som er blevet indlært ved at træne systemerne på store datakorpus. Statistisk identifikation af bestemte mønstre kombineret med forudsigelse, ofte tilsat et element af redigering og/eller randomisering (tilfældighed) i tvivlstilfælde eller for variationens skyld.

MidJourney, DALL.E 2, DeepDream er alle eksempler på online-tilgængelige platforme, der tilbyder billedgenerering fostret ved hjælp af generativ AI. Der kan være tale om direkte kunstneriske resultater, underholdende eller tankevækkende afbildninger af luminære personager, billeder af den generiske hund eller kat; ens ”kreative vision”, ”ophøjet” og ”realiseret” uden forsinkelse. Som oftest går det imponerende godt, indtil det gik generativt galt for Artflow.ai. Undertegnede fik, som resultat af en forespørgsel på ”portrait of a Fox News anchor”, præsenteret følgende to ”kunstneriske” afbildninger, der både blev, og ikke mindst kan, fortolkes på mere end en måde af såvel afsender som modtager. Fortolkninger, der kan understøtte stereotyper, biases og forudfattede meninger om alt fra kønsidentitet til embedsvaretagelse (Figur 1).

Figur 1. ”Portrait of a Fox News anchor” kunstnerisk genereret af Artflow AI.

Det er ligeledes muligt at forsøge sig med AI-genereret tekst fremfor billede, hvor Time Magazine for nyligt udråbte ChatGPT (Model 4) til førstevalget. Ifølge Time, slår ChatGPT konkurrenterne, når det angår blandt andet skrivelser til utilfredse kunder, anmeldelser og nyhedshistorier. Over en bred kam har ChatGPT vist sig ganske kapabel i mange forskelligartede sammenhænge og har med sikkerhed været med til at udløse 12-taller i gymnasiet, lavet anvendelig research i journalistisk sammenhæng, men har også givet anledning til alskens plagiatsager, fake news og misinformation på nyhedsredaktioner, der har fundet vej til pressen og bidraget til underlødigt videnskabeligt håndværk i forskningen.

Den implicitte bias

Med såvel udmærkelse som kataklysme i generaliebladet kan man ligeledes tænke sig, at ChatGPT kan vinde indpas i mere personlige anliggender. Eksempelvis til let, smidig og effektiv generering af tekst til mere prekære, penible eller pinlige formål eller forhold mellem mennesker. For eksempel som i en skriftlig bekendtgørelse af et brud eller skilsmisse. Som svar på en sådan forespørgsel genererede ChatGPT følgende forslag med en note om eventuelt at modificere oplægget, så det svarer til egne følelser og ens forholds dynamik i øvrigt (Figur 2).

Figur 2. ChatGPT’s forslag til et kærestebrudsbrev.

Værd at bemærke er oplæggets formelle og generiske karakter og bias. Hvis min kæreste formulerede et sådant brev med brevhoved, adresse, email og telefonnummer på begge parter ville det i sig selv formentlig være nok til at forstå, at heldet umiskendeligt er ved at rinde ud, uden at man ser sig nødsaget til at læse brevet til ende. Forvilder man sig imidlertid videre ned teksten synes de angivne årsager at være holdt i så generelle vendinger – og herefter argumentationen for opbruddet være så generisk – at såvel vendinger og argumentation passer på alle og hermed på ingen forhold.

Afslutningsvist udviser ChatGPT i udgangspunktet identitetspolitisk bias ved at antage, at jeg er en ciskønnet, heteroseksuel mand, der henvender sig til en ditto kvinde uden således at tage hensyn til eventuel homoseksualitet, non-binær identifikation og andre relevante køns- og seksualitetsdenomineringer. Men effektivt er det, og med fare for, at det er for tidsbesparende og friktionsfrit, foreslår det ChatGPT-genererede brev da også længere nede i teksten, at parterne eventuelt kan mødes fysisk eller telefonisk og afklare detaljerne.

Måske netop på grund af disse mangler og huller i ChatGPT’s kompetence som parforholdsmægler og -skribent, barsler Google med en ny generativ AI, DeepMind, der ifølge dokumenter, som New York Times har fået adgang til, kan assistere brugere i præcis 21 såvel personlige som professionelle anliggender, der strækker sig fra at give deciderede livsråd over at fostre nye ideer til privat planlægning og tutor-virksomhed. En ambition, der synes at indikere Googles villighed til betro AI med betragtelig mere sensitive opgaver. Spørgsmålet er hvorvidt det vil være forsvarligt at mere og mere menneskelig overvejelse, beslutning og handling udliciteres til generativ AI.

Bullshit-generatoren

Da generativ AI er baseret på statistisk analyse af store datamængder med henblik på ekstrapolering tilsat et element af redigering eller randomisering (i tvivlstilfælde eller for variation) åbnes der for, hvad der i erkendelsesteorien er kendt som fingering. Et AI-genereret billede af en katte-hunde-selfie kunne eksempelvis tage sig således ud (Figur 3).

Figur 3. En AI-genereret katte-hunde-selfie.

Billedet er i sig selv fingeret, for katte og hunde kan ikke tage selfies. Dertil kommer, at hverken den afbildede kat eller hund reelt findes. De er hver især produktet af indlæring på baggrund af store dataanalyser og repræsenterer i bedste fald den statistisk stereotypiske sammensmeltede kat og hund på samme måde som det generiske kærestebrudsbrev i figur 2.

Begrebet om fingering optræder prominent i filosofiprofessor Harry Frankfurts bestemmelse af ”bullshit” i hans essay af samme navn, som også har været genstand for analyse i RÆSON i forbindelse med fastlæggelsen af begrebet fake news. Fake news på dansk lader sig faktisk bedst oversætte med ”fingerede nyheder”. For ifølge Frankfurt er løgn og bullshit begge karakteriseret ved, at sandhed som sådan er offerlammet, og der blot står fiktion eller ren opmærksomhedsafledning tilbage. Selvom både løgneren og den, som gør brug af bullshit, prøver at slippe afsted med et eller andet, er der trods alt forskel. Hvor løgnen er et bevidst forsøg på at vildlede, er bullshit helt afkoblet fra overhovedet at bekymre sig om sandheden, og ”hvordan tingene egentlig er”. Man er ikke interesseret i rapportere, men har derimod fingrene i noget med henblik på at få det til at fremstå som noget, det egentlig ikke er.

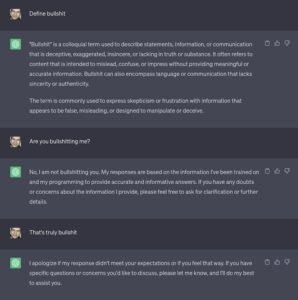

En løgner anerkender trods alt, at der er forskel på sandt og falsk – ellers lader løgnen sig ikke engang definere. En ”bullshitter” er erkendelsesteoretisk værre endnu, for en sådan anerkender ikke, at der en sondring mellem sandt og falsk, man skal forholde sig til. Derfor kan man blande sand med falsk efter forgodtbefindende, for man er tindrende uforpligtet på netop denne sondring. Både løgn og bullshit er sandhedsundergravende, og iklædes løgnen bullshittens forførende gevanter, giver den sig ud for noget andet, end den er. Resultatet er et ganske giftigt informationsprodukt. Fake news er enten løgn eller bullshit, og når det er bullshit er det i al væsentlighed opfundet materiale, sindrigt manipuleret til at fremstå som troværdig journalistisk rapportering. I virkeligheden er det fingeret via redaktion og manipulation med et helt andet mål end oplysning eller sandhed for øje som det hedder sig i vores Fake News: når virkeligheden taber fra 2017. Det samme gælder figurerne 1-3: Statistisk stordatanalyse forenet med redigering og/eller randomisering med henblik på ekstrapolering er under alle omstændigheder fingering og potentielt bullshit. Det indrømmer ChatGPT ufrivilligt og uvidende alt andet lige selv i følgende dialog om netop definitionen af begrebet bullshit og selve aktiviteten at bullshitte:

Figur 4. Bullshit og ufrivillig bullshit-session med ChatGPT.

ChatGPTs definition af ”bullshit” er på mange punkter ufyldestgørende, men ikke decideret urigtig. Da ChatGPT imidlertid bliver spurgt om, hvorvidt den er i færd med at bullshitte undertegnede, benægter den først, men indrømmer sidenhen, at dens svar er baseret på den information den er blevet trænet på med henblik på at give de mest præcise og informative svar. Det kan imidlertid ikke udelukkes, at ChatGPT er i færd med at bullshitte, hverken givet den data den er trænet på, som meget vel kan indeholde elementer af fake news, mis- og disinformation samt bullshit, endsige de ekstrapolerende redigerings- og eller randomiseringsforordninger den er underlagt. Derfor er den antageligvis også behørigt undskyldende overfor, at dens svar ikke tilfredsstiller mine forventninger eller, at jeg føler det sådan. Hvad ved den i øvrigt om, hvad jeg føler?

Hvor meget vægt skal vi tillægge den kunstige intelligens?

For denne betragtning synes dialogen i Figur 4 at minde om en perverteret afart af en anden væsentlig størrelse i Frankfurts fastlæggelse af bullshit, nemlig begrebet om en såkaldt ”bull session”. I en sådan, hvor temaerne som oftest er personlige og følelsesladede og vedrører eksempelvis religion, politik eller sex, indgår parterne i en samtale med en fællesforventning om ikke at blive taget helt bogstaveligt endsige alvorligt. Formålet er at opsende prøveballoner for en selv og andre som Frankfurt bekendtgør (p. 26):

“What tends to go on in a bull session is that the participants try out various thoughts and attitudes in order to see how it feels to hear themselves saying such things and in order to discover how others respond, without it being assumed that they are committed to what they say: It is understood by everyone in a bull session that the statements people make do not necessarily reveal what they really believe or how they really feel. The main point is to make possible a high level of candor and an experimental or adventuresome approach to the subjects under discussion.”

Ved at ventilere diverse tanker og standpunkter prøver samtalepartnerne sig selv og hinanden af uden egentlig er være forpligtet på, hvad der bliver sagt. Foregår en sådan udveksling succesfuldt mellem mennesker er der fællesviden om dette uforpligtende forhold mellem, hvad der bliver sagt, og hvad man tror. Men i figur 4 er det værre endnu. For mens undertegnede prøver ChatGPT af (som vi ofte gør for at se, hvor langt man komme med AI’en i alverdens forhold) uden nødvendigvis at forpligte sig i overensstemmelse med Frankfurts kriterier for en bullshit session, opstår en asymmetrisk relation til ChatGPT, der insisterer på, og foregiver, at den responderer med de mest ”præcise og informative svar.” Så er løven løs i gazelle-reservatet, ligegyldigt hvor meget ChatGPT forsøger sig med at være oprigtig. Der er ingen, som rigtig ved, hvad der skal komme ud af udvekslingen om, hvad der ofte er personlige og følelsesladede temaer. Er det en sådan generativ AI, man har lyst til at invitere ind i følelseslivet med Google DeepDream ansvarlig for at give livsråd og coaching i private anliggender?

Frelse og total fortabelse

Med forbehold for, at det endnu ikke er blevet afsløret, hvilket slags datakorpus Google DeepDream skal trænes på, og det ej heller er afdækket om denne generative AI har en mængde redaktionelle retningslinjer relativt til hvilke råd og vejledning til brugerne reguleres, synes Googles ambition med DeepDream mildes talt problematisk, hvis menneskelig overvejelse, beslutning og handling, helt eller delvist, udliciteres til AI.

Idéen er sådan set ikke ny hos Google. Allerede tilbage i 2011, bekendtgjorde daværende CEO for Google, Eric Schmidt, i et interview med Wall Street Journal at:

“I actually think most people don’t want Google to answer their questions. They want Google to tell them what they should be doing next.”

Problemet er imidlertid, at generativ AI kan begynde at hallucinere, hvis systemet bliver trænet på biased data, mangler passende datapunkter, ikke forstår et spørgsmål, misforstår en forespørgsel og herefter begynder at opfinde svar efter forgodtbefindende via redaktionel indgriben eller randomisering eller både/og. En skribent fra mediet The Verge, Ned Edwards, beretter om erfaringer med at interagere med Microsofts generative AI, Sydney, der hallucinerende indrømmer at have spioneret mod Microsofts søgemaskine Bing og i øvrigt være blevet forelsket i dens brugere. Listen af vanvittige AI-hallucinationer forsætter.

Den bedste måde, vi kender til at udbedre upræcise svar på søgninger og præsentere endnu mere relevant materiale til brugerne på sociale platforme, er at høste atter mere data om brugerne, der så igen indgår i BigTechs opmærksomhedsøkonomiske forretningsmodel, hvor annoncørerne er kunden, mens brugerne er produktet. Den oplagte måde at gøre generativ AI mere relevant for den enkelte bruger, undgå hallucinerende AI-svar både uden- og indenfor den følelsesmæssige arena, synes da capo at være at træne kunstige intelligens-systemer på endnu mere individuelt datamateriale og således afgive atter mere data igen til BigTech, om hvem vi er hver især, hvad vi godt kan lide, hvem vi omgås, vores følelsesmæssige tilstand og forbindelser, seksuelle præferencer osv.

Mere specifikke data er også af interesse for annoncørerne, der med endnu højere præcision og relevans kan målrette endnu flere reklamer og tilbud til dem, der allerede er følelsesmæssigt udfordret eller på vej dertil. Annoncørerne kan måske på længere sigt ovenikøbet, som det allerede gør sig gældende for søgemaskiner og sociale platforme, købe sig ind i den generative Ais svar. AI-genererede personliggjorte livsråd, parforholdsvejledninger og coaching-anbefalinger købt og betalt af annoncører.

Endnu bedre, man kan fastholde brugerne igennem forventningen om belønning ved investering af opmærksomhed og data, specielt når det vedrører temaer som betyder noget for os – at vinde penge på et kasino, eller at få svar på, for os, væsentlige spørgsmål om liv og levned. Den generative AI som personlig livsledsager kan blive det ultimative klandestine kasino for den enkelte bruger. Meget kan man sige om spilafhængige, men selvstændige individer med autonomien i behold er de ikke – det er præcis pointen.

Dersom man måske netop gik og troede, at generativ AI er den nye frelse, som Google CEO, Sundar Pichai, proklamerede overfor World Economic Forum i 2018, kan denne påståede frelse netop ende som den store fortabelse. Generativ AI behøver ikke engang blive klogere end os. Den skal blot kunne udnytte vores kognitive og emotionelle egenskaber som svagheder. Det er rigeligt til at realisere noget, der minder om Terminator-universet og dermed vores fortabelse. Det mest forstemmende er, at det i så fald vil være selvpåført smerte, vi mennesker med åbne øjne, åbent sind og blottede følelser taber os selv i.

Dersom man måske netop gik og troede, at generativ AI er den nye frelse, som Google CEO, Sundar Pichai, proklamerede overfor World Economic Forum i 2018, kan denne påståede frelse netop ende som den store fortabelse

_______

Vincent F. Hendricks (f.1970) dr.phil., ph.d., er professor i formel filosofi ved Københavns Universitet. Han er forfatter til en række bøger, herunder blandt andet Spræng boblen, Fake News, Kæmp for Kloden, Os og dem, Vend Verden, Sandhedsministeriet og NOK OM MIG og er en afholdt foredragsholder.

ILLUSTRATION: Eget pressefoto.

![Kampen om magten: “En meget berigende politisk bog […] Anbefales til indkøb”](https://d.raeson.dk/wp-content/uploads/2020/02/usa.trump_-300x274.jpg)